Comprendere le reali emozioni dei lettori di una pagina web o di una pubblicità online è da sempre il sogno segreto di pubblicitari, scrittori, designer e direttori marketing.

A partire dal primo decennio del 2000, questo sogno è iniziato ad avverarsi grazie all’esordio sul mercato delle prime piattaforme di riconoscimento delle emozioni per finalità commerciali offerte a prezzi accettabili.

Un esempio tutto italiano è Miora, sistema lanciato sul mercato nel 2018 dalla startup Emoj, uno spin-off accademico dell’Università Politecnica delle Marche, che opera su siti web e piattaforme per la vendita online per ottimizzare la conversione dei clienti tramite l’analisi delle espressioni del loro volto.

In Miora, il monitoraggio delle espressioni del viso avviene attraverso una semplice videocamera. Si può utilizzare infatti quella dello smartphone, di un pc o del tablet del soggetto osservato, oppure si possono usare le immagini riprese da una telecamera ambientale installata all’interno del punto vendita.

I moduli disponibili nel software sono due: uno di Emotional Analytics, che oltre a rilevare e riconoscere le emozioni , traccia lo sguardo e individua le aree che attirano maggiormente l’attenzione; il secondo di Emotional Intelligence, che adatta l’interfaccia per corrispondere alle esigenze del cliente, attiva un remarketing mirato ed esegue A/B testing in automatico.

La tecnologia di EMOJ può operare online, offline, in laboratorio o direttamente sul campo, con una grande flessibilità d’uso e notevoli risparmi rispetto alla ingombrante e invasiva strumentazione che spesso viene adottata nel neuromarketing (elettroencefalogramma, brain imaging, eye tracking).

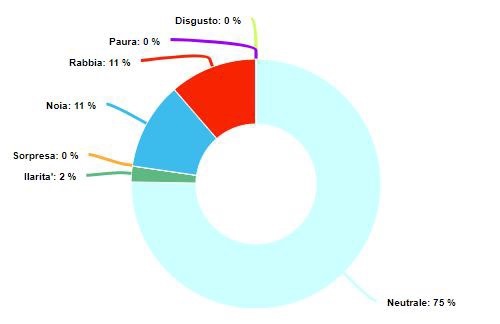

I risultati vengono resi sotto forma di mappe di calore, grafici e curve emozionali che mostrano le diverse emozioni provate per ogni singolo passaggio o azione compiuta sulla pagina web (o nel punto vendita) dai vari gruppi di soggetti osservati.

Il raggruppamento può avvenire per età o per genere. Non vengono mostrati i dati biometrici dei singoli soggetti per tutelarne Privacy e perché è molto più interessante capire le attitudini ed i comportamenti di gruppi.

Per chi fa un utilizzo dell’applicazione con finalità specificatamente rivolte alla rete, l’effetto finale ricorda i tradizionali strumenti di tracciamento on-page che fanno uso dell’analisi dei click del mouse (tipo Hotjar, per intenderci), ma con la fondamentale differenza che in questo caso viene aggiunto anche il rilevamento delle emozioni e del movimento oculare.

Il monitoraggio del grado di attenzione dell’utente avviene tramite il tracciamento dello sguardo, una delle principali innovazioni di questo prodotto.

L’importanza di disporre di una banca dati adeguata

“Il problema di questo tipo di tecnologie non sta tanto nella complessità dell’algoritmo, ma nella necessità di disporre di una banca dati contenente milioni di espressioni del viso”, mi spiega al telefono il prof. Sebastiano Battiato, ordinario di informatica all’università di Catania ed esperto di Computer Vision.

Luca Giraldi, prima ricercatore presso la Politecnica di Ancona e oggi CEO di Emoj, conferma che: “La vera difficoltà nello sviluppare Miora è stata la costruzione del database necessario per addestrare l’intelligenza artificiale al riconoscimento delle emozioni facciali”.

“Basta pensare che la quantità di immagini minima di cui bisogna disporre supera il milione. La nostra banca dati ne ha oggi più di cinque, e ci abbiamo messo oltre 4 anni a costruirla. Inutile dire che costituisce l’asset centrale di questo genere di applicazioni”.

Il bisogno di avere sotto mano di big data di questo tipo spiega i tempi lunghi di sviluppo del prodotto e la necessità di appoggiarsi al mondo della ricerca, in particolare all’università, a pena di errori che si possono rivelare pericolosi.

Questo genera automaticamente delle forti barriere tecnologiche all’ingresso nel mercato. E, in effetti, i concorrenti di Emoj sono pochi: qualche startup europea (Angus.ai, in Francia, che lavora con Carfour; iMotions in Danimarca, legata al gruppo Nielsen), e gli statunitensi di Affectiva, i pionieri di questo settore.

Il ruolo dell’intelligenza artificiale nel riconoscimento delle espressioni facciali

“Anche se in teoria un software di riconoscimento delle espressioni facciali potrebbe funzionare anche senza intelligenza artificiale, nella pratica questa scelta sarebbe estremamente complessa da gestire”, precisa il prof. Battiato.

L’intelligenza artificiale risolve infatti tutta una serie di problematiche pratiche a una velocità a cui l’operatore umano non sa fare fronte, rendendo competitivi costi e prestazioni. Nascono però nuovi problemi.

“Una volta che si dispone della banca dati, bisogna poi addestrare l’intelligenza artificiale del software su di essa”, mi spiega Giraldi. “Questo vuol dire spendere parecchio tempo e molti soldi. L’operazione di addestramento va ripetuta per ogni tipo di utilizzazione”.

“Non è quindi la stessa cosa avere un software addestrato per l’ecommerce e lo stesso software addestrato sui punti vendita delle case di produzione di lavatrici.”

“Le faccio un esempio preso dalla vita di tutti i giorni: una Ferrari e un trattore hanno entrambi alimentazione a benzina, motore da 6000 cavalli e sono veicoli su quattro ruote gommate: eppure il contesto di impiego ne cambia radicalmente forme e prestazioni. La stessa cosa accade per i software di riconoscimento delle emozioni facciali: una cosa è lavorare per l’e-commerce, un’altra per la sicurezza ”.

Le microespressioni facciali e il problema dell’accuratezza

Un’altra difficoltà da risolvere è quella dell’ interpretazione delle emozioni in base alle espressioni del viso: il significato delle microespressioni del volto è ancora oggi un problema discusso in psicologia.

Il modello di riferimento generalmente accettato da chi sviluppa questo tipo di software è quello dello psicologo Paul Eckman, che riconosce sei emozioni universali comuni a tutti i popoli e a tutte le culture (rabbia, disgusto, tristezza, gioia, paura sorpresa).

Oltre ad avere il pregio dell’universalità (applicazione a utenti di qualsiasi razza e paese) e di un vasto (anche se non unanime) consenso tra gli studiosi, il modello di Elkman include anche delle strategie per individuare se una persona mente o meno.

Tuttavia, la dipendenza da questo modello degli attuali applicativi di riconoscimento delle emozioni facciali potrebbe rivelarsi un loro tallone d’Achille in futuro. Il prof. Battiato osserva però che questi software stanno mostrando una verifica empirica sempre più robusta, soprattutto per il riconoscimento dell’età e del genere.

Inoltre, pare che ci sia sufficiente consenso scientifico almeno sulle sei emozioni universali del modello, vertendo la discussione su aspetti che attualmente non sono gestiti da queste piattaforme.

In conclusione, la possibile falsificazione della teoria di Eckman non compromette necessariamente la validità delle rilevazioni e quindi dell’utilizzo di questo tipo di software, almeno per gli usi di tipo commerciale.

Diverso il discorso per ambiti più delicati: su questo punto, il prof. Battiato chiarisce che per la sicurezza e la giustizia le perplessità e le riserve sulla sua applicazione sono ancora molte.

Privacy e riconoscimento delle emozioni facciali

La privacy e i suoi mille adempimenti sono indubbiamente una problematica non trascurabile per chiunque desideri utilizzare piattaforme di riconoscimento delle emozioni facciali. La buona notizia è che questo tipo di tecnologia risolve l’aspetto più spinoso, quello della raccolta dei dati sensibili.

“Anche se viene utilizzata una telecamera, i dati biometrici vengono completamente anonimizzati. Le immagini infatti restano all’interno dell’applicazione che le elabora tramite le tecniche che adottiamo di intelligenza artificiale e poi restituisce le informazioni come età, genere ed emozioni in forma completamente anonima”, prosegue Giraldi.

“In sintesi, ai fini privacy è sufficiente l’autorizzazione alle riprese. L’identità dei soggetti non viene rivelata dal software, e non vengono prodotte immagini che mostrano il suo viso; in questo modo i dati sensibili sono pienamente tutelati”.

Il prof. Battiato chiarisce infine un dettaglio non trascurabile per chi tiene alla riservatezza: “Nell’intelligenza artificiale, è la macchina stessa a elaborare e costruire le decisioni e alcune parti del software che utilizza, creando una sorta di scatola nera a cui i programmatori non hanno accesso”.

Le prospettive future

Il mercato dei dispositivi di riconoscimento delle emozioni, di cui i dispositivi di rilevamento facciale fanno parte, dovrebbe arrivare nel 2024 a circa 100 miliardi di dollari, con una crescita del 40% annuo.

Per l’Italia si può prendere per riferimento proprio Emoj, che opera attualmente in regime di sostanziale monopolio: nel 2019, secondo anno di esercizio della startup, i progetti arrivavano già alla trentina con un fatturato intorno ai trecentomila euro.

La ricerca punta oggi ad ampliare il riconoscimento delle emozioni includendo i gesti e il contesto in cui opera il soggetto. Dopo le applicazioni in ambito neuromarketing, l’obbiettivo è quello di creare dispositivi per la sicurezza della guida, in grado, ad esempio, di rilevare l’attenzione del guidatore e prevenire incidenti potenzialmente gravi, come il classico camionista che addormentandosi sbanda in corsia.

Questi dati fanno riflettere sulla potenziale importanza di un settore che nei prossimi anni potrebbe influire profondamente nella nostra vita quotidiana e in particolare sul lavoro di chi scrive, in particolar modo per gli autori di contenuti per il web.

Volto specchio dell’anima dunque? Dopotutto, interpretare le emozioni leggendo le espressioni del volto è un problema antico come l’uomo: la prima teoria risale addirittura a Pitagora, e siamo nel V secolo A.C.

Le piattaforme di riconoscimento delle emozioni facciali non fanno altro che fornire forma e ausilio tecnologico a un’attività che l’umanità ha sempre fatto e sempre farà, correggendo l’imprecisione dell’empiria col rigore della scienza.

Si ringraziano il prof. Sebastiano Battiato – ordinario all’università di Catania, founder e Scientific Advisor dello spin-off dell’università di Catania iCTlab– e il dr. Luca Giraldi, CEO di Emoj e ricercatore presso il Politecnico di Ancona, il cui aiuto e collaborazione ha reso possibile la redazione di questo articolo.

Ti è piaciuto questo articolo? Iscriviti alla newsletter per ricevere contenuti simili. Oppure, leggi il mio ultimo libro, Neuroscienze della narrazione.

Per approfondire:

Articolo del 2018 dei ricercatori dell’Università Politecnico delle Marche sullo stato dell’arte degli strumenti per rendere l’esperienza di acquisto sensibile alle emozioni del cliente.

Un’analisi del prof. Sebastiano Battiato di come la computer vision e il riconoscimento visivo delle emozioni giocheranno un ruolo chiave nella gestione dei punti vendita.

Una panoramica sulla teoria di Paul Eckman e i suoi critici

Un rapporto sulle prospettive del mercato dei dispositivi di riconoscimento delle emozioni.

Per chi fosse interessato a contattare il dr. Luca Giraldi o il prof. Sebastiano Battiato:

Prof S.Battiato:

Linkedin: https://www.linkedin.com/in/sebastianobattiato/

Twitter: @sebattiato

Dr. L. Giraldi

Linkedin: https://www.linkedin.com/in/giraldiluca/