Che sia possibile misurare le emozioni con le strumentazioni e le metodologie delle neuroscienze è ormai sulla bocca di tutti. Eppure, pochi conoscono il ruolo decisivo che hanno avuto i ricercatori italiani nell’aprire la strada all’applicazione di strumentazioni come l’eye-tracking e i sensori biometrici.

Tra i protagonisti troviamo Maurizio Mauri, psicologo, professore a contratto all’università Cattolica e Head of user experience & neuromarketing research di SR Labs The Eye Tracking Company. La sua storia inizia nei primi anni 2000 al Politecnico di Milano, poco dopo la fine di quello che George Bush aveva definito il: “decennio del cervello”.

Per le neuroscienze, sono anni decisivi. Nelle severe aule della massima eccellenza tecnologica lombarda si incontrano e si conoscono alcuni dei personaggi destinati a scrivere la storia del neuromarketing italiano, come Francesco Gallucci.

Maurizio mi racconta che: «In quegli anni ero alle prese con la mia tesi di dottorato presso l’Università IULM, grazie alla collaborazione con un professore ordinario di Psicologia: Marco Alessandro Villamira.

Un problema che aveva il Politecnico di Milano era che i corsi a distanza non veicolavano lo stesso livello di apprendimento rispetto a quelli tenuti in sede, anche se i materiali didattici erano gli stessi: in particolare, i corsi tenuti in presenza veicolavano livelli di apprendimento più elevati Grazie alla collaborazione del prof. Villamira dell’Università IULM di Milano con il prof. Alberto Colorni del Politecnico e all’ing. Stefano Scotti del Centro Metid da un lato e il dipartimento di Bioingegneria, con il prof. Sergio Cerutti e il prof. Luca Mainardi dall’altro, si era tematizzato come obiettivo di ricerca uno studio sperimentale per superare questo limite dei corsi a distanza o “e-Learning”.

Dopo varie esplorazioni, si scoprì che l’anello mancante sembrava essere il “coinvolgimento emotivo”. Non bastava avere dei contenuti ottimizzati dal punto di vista grafico, facili e a basso carico cognitivo; gli studenti si sarebbero comunque annoiati senza coinvolgimento emotivo, e per questo il loro livello di apprendimento era più basso. E dovendo tenere lezioni “a distanza”, il docente non si può certo rendere conto se la classe stia attenta al materiale didattico oppure stia dormendo, e non è sempre facile tenere alto il coinvolgimento emotivo dell’aula “virtuale”.

Per risolvere il problema, gli ingeneri del Politecnico decisero di parlare con gli psicologi, e lì entrai in campo grazie ad una ricerca antecedente: nei due anni precedenti avevo lavorato per il centro di ricerca dell’istituto Auxologico Italiano con il prof. Giuseppe Riva su un grosso progetto europeo che studiava la realtà virtuale (progetto E.M.M.A., “Engaging Media for Mental-health Applications”), con l’incarico di misurare le emozioni generate in quel tipo di ambienti sintetici che si ponevano l’obiettivo di stimolare emozioni nelle persone per migliorarne il benessere psicologico.

All’epoca non esisteva un metodo condiviso dalla comunità scientifica per misurare le emozioni. Anzi, il dibattito sul tema della misurazione delle emozioni era molto acceso fin dagli albori della psicologia da parte dei padri fondatori: da una parte scienziati che ritenevano impossibile misurare la reazione emotiva di una persona, in quanto troppo legate alla dimensione soggettiva delle esperienze, dall’altra uno schieramento di studiosi, accusati spesso di essere dei “riduzionisti”, che cominciavano a mettere in discussione la tesi tradizionale.

La lettura di un libro di Antonio Damasio, dal titolo “L’Errore di Cartesio”, in cui l’autore svelava le radici biologiche delle emozioni, mi aveva ispirato e convinto che fosse possibile caratterizzare e quantificare le emozioni grazie ai loro correlati biologici. In altre parole, grazie alle neuroscienze, che stavano iniziando a svelare la natura profondamente biologica dei fenomeni mentali.

In realtà, già dalla mia tesi di laurea sui messaggi subliminali emotivi, conseguita nel 2001, avevo constatato che si potevano escogitare delle tecniche sperimentali per misurare l’efficacia di messaggi emotivi, e da allora, quasi fosse diventata una sfida personale, avevo deciso di dedicarmi a questo specifico tema di ricerca: rendere “tangibile” ciò che sembrava essere “intangibile”, ovvero “reificare” una esperienza emotiva; il mio percorso di studi potrebbe essere riassunto dal leit motive “sulle tracce delle emozioni”, e il lettore abbastanza paziente da terminare la lettura di questo articolo potrà giudicare da solo se sono riuscito a realizzare questa impresa.

A quell’epoca, gli unici strumenti accettati dalla comunità scientifica per misurare le emozioni percepite erano dei questionari, con delle scale psicologiche, ma erano “mezzi spuntati”. Grazie ai primi studi sugli ambienti virtuali, mi ero reso conto che si potevano usare le misure psicofisiologiche come la sudorazione della pelle, il respiro e, il battito cardiaco per tentare di misurare maggiore o minore emozione suscitato dall’ambiente virtuale “A” se paragonato all’ambiente virtuale “B”

“All’Auxologico avevo fatto un esperimento con 4 diverse “versioni” dello stesso ambiente virtuale. Le teorie scientifiche postulavano che per generare emozioni in ambienti virtuali i fattori erano principalmente 3: tecnologia (maggiore “definizione grafica”, maggiore coinvolgimento emotivo), narrazione (maggiore “senso” – fatto di scopi, motivazioni e obiettivi da raggiungere – l’utente trovava nella esperienza sintetica, maggiore il coinvolgimento emotivo), interazione (maggiore capacità del sistema di rispondere adeguatamente alle azioni dell’utente o maggiore “immersività” del setting, si otteneva allora maggiore coinvolgimento); avevamo testato questi fattori utilizzando lo stesso ambiente virtuale, un piccolo ospedale che gli utenti potevano esplorare attraverso diverse 4 modalità:

- Un semplice computer, senza alcuna “narrazione” (istruzioni date ai partecipanti: “Prova a entrare nell’ospedale, e cerca il laboratorio per le trasfusioni di sangue).

- Un computer dotato di collegamento con visore di realtà virtuale di ultima generazione, attrezato con un sensore di movimento, capace di far ruotare l’ambeinte virtuale se la persona ruotava il capo, in tutte le direzioni, coerentemente con i movimenti del partecipante; ma sempre senza alcuna “narrazione” (come al punto 1).

- Un semplice computer (come al punto 1), ma con la “narrazione” (le istruzioni date ai partecipanti erano: “L’ospedale è stato evacuato, a causa di un virus sfuggito al controllo dei ricercatori, ma contiene ancora sacche di sangue in grado di salvare tante persone infettate: trova il sangue ed evita l’unico paziente psichiatrico rimasto all’interno dell’ospedale, un paziente schizofrenico completamente imprevedibile e potenzialmente molto pericoloso!”).

- Un computer dotato di collegamento con Visore di realtà virtuale (come al punto 2), ma con la narrazione (come al punto 3).

Le persone che parteciparono alla ricerca (circa una trentina), erano monitorati con sensori che rilevavano: la sudorazione della pelle, il battito cardiaco e il respiro. Indovinante quale “setting” generava le reazioni psicofisiologiche più importanti? Scoprii che il massimo coinvolgimento si aveva quando c’era la narrazione abbinata alla tecnologia interattiva maggiore (punto 4): nel caso in questione il partecipante si calava nei pannidi una sorta di agente che doveva evitare di contrarre il virus, evitare di incappare in un paziente impazzito, e portare a termine la missione per salvare più gente possibile.

Le reazioni emotive correlate alle accelerazioni cardiache più importanti, ai livelli più elevati di sudorazione e ai ritmi respiratori più intensi si rivelavano non solo quando i partecipanti trovavano la stanza delle trasfusioni nello scenario 4, ma addirittura erano ancora più intense quando “incontravano” il paziente impazzito (rappresentato da un “avatar” che camminava in tondo, all’interno del corridoio sul quale tutti i partecipanti dovevano passare per raggiungere la stanza delle trasfusioni al’ultimo piano dell’ospedale). Confrontando tuttavia lo scenario 2 (alta tecnologia, SENZA narrazione) con lo scenario 3 (bassa tecnologia, ma CON narrazione), le emozioni erano più “forti” in termini di reazioni psicofisiologiche, nello scenario 3: in poche parole, tra tecnologia e narrazione, vinceva la narrazione! Ca va sans dire, unendo narrazione + tecnologia, si ottenevano le emozioni più importanti.

Tutti i risultati della ricerca sono stati pubblicati su rivista scientifica internazionale nel 2004 (F. Mantovani, M. Mauri, G. De Leo, M. Mantovani, G. Castelnuovo, A. Gaggioli, G. Riva. “Narrative dimension, sense of presence, and emotional involvement: an experimental analysis”. Cyberpsychology & Behavior, 7(3), 296-297, 2004).

Memore di questa esperienza, proposi agli ingegneri del Politecnico di usare la psicofisiologia per testare il coinvolgimento emotivo durante i moduli di insegnamento a distanza. Il primo test fu con un campione di 30 studenti, ambosessi.

I soggetti venivano fatti sedere davanti a un computer e usufruivano di un modulo di formazione a distanza, dove dovevano apprendere delle informazioni su uno stato africano inventato e poi rispondere a dei quiz volti a valutare il livello di apprendimento delle informazioni relative alla geografia, economia e cultura dello stato africano. Noi misuravamo tutte le loro reazioni in termini di: sudorazione della pelle, battito cardiaco, respiro, e segnali elettroencefalografici (EEG) presi in un solo punto (sulla sommità del capo, detto “CZ”, facendo riferimento alla nomenclatura internazionale 10-20 per la misurazione di segnali EEG).

Ci eravamo resi conto che era difficile affermare che un aumento del battito cardiaco volesse dire più emozioni, a causa della eccessiva variabilità di risposte psicofisiologiche tra un individuo e un altro. Dovevamo trovare un modo di “standardizzare la misurazione delle emozioni”, prima rilassando i soggetti e poi misurando la variazione tra lo stato a riposo e quello di eccitazione. In poche parole, per definire lo stato di coinvolgimento emotivo di ogni singolo partecipante, dovevamo avere:

– sia un “punto di paragone” per quando la persona era rilassata (ovvero in stato emotivo “neutro”, privo di una emozione specifica);

– sia un benchmark della stessa persona quando “molto emozionata negativamente” o “stressata”;

Una volta escogitato il modo di elicitare e “fotografare” la configurazione dei parametri neuro- e psico-fisiologici di questi due stati “estremi”, quasi “opposti”, per ogni partecipante, allora si sarebbe potuta “tarare” o “calibrare” (e interpretare meglio) la reazione degli studenti ai materiali didattici usati nell’esperimento.

Il progetto venne giudicato interessante dal Politecnico, e riuscimmo quindi a svolgere una prima sperimentazione con successo; tutti i dati di questo primo studio sono stati pubblicati nel 2005: qui il riferimento bibliografico consultabile online: https://ieeexplore.ieee.org/abstract/document/1616638.

Nel frattempo sia per portare avanti gli studi nel campo, sia per fare una esperienza all’estero durante il mio dottorato, avevo applicato e poi in seguito vinto una borsa di studio per continuare il mio dottorato presso il MIT (Massachusetts Institute of Technology) di Boston, negli Stati Uniti, uno degli istituti di ricerca più prestigiosi del mondo, grazie alla partecipazione di un bando del MIT-Italy Program, gestito allora dalla professoressa Serenella Sferza.

Decisi di fare di questo progetto sul tema della misurazione del coinvolgimento emotivo tramite l’uso di parametri neuro- e psico-fisiologici il mio argomento di tesi dottorale. Più precisamente, il mio obbiettivo era trovare un modo di “calibrare” la misurazione delle emozioni su base individuale, usando i parametri neuro- e psicofisiologici (sudorazione, respirazione, battito cardiaco e segnali elettroencefalografici). L’idea era di percorrere due strade: da una parte, applicare “algoritmi” più sofisticati per “estrarre informazioni emotive” dai dati sperimentali già collezionati; dall’altra, ripetere nuovi studi e verificare se emergevano risultati uguali o simili: se ciò si fosse verificato, allora sarebbe stata la prova che la strada era quella giusta. Una volta iniziata la mia esperienza americana nell’agosto del 2005, scoprii il campus del MIT : un campus enorme, una sorta di piccola cittadella all’interno del tessuto urbano di Boston, costeggiata a sud dal Charles river. Il dipartimento di scienze cognitive era diventata la mia “casa” americana; in particolare, il laboratorio di Neurostatistica del professore Emery Neal Brown e del suo assistente prof. Riccardo Barbieri. L’ambiente era da fantascienza, il cervello veniva studiato sotto ogni punto di vista presso il “Brain and Cognitive Science Department” (BCS) del MIT.

Il dipartimento è diviso in tre poli: uno dove prevalevano gli psicologi (BCS), uno dove prevalevano i biologi (Picower Institute for Learning and Memory) e uno dove invece prevalevano ingegneri e fisici (Mc Govern Institute for Brain Research); vicino al dipartimento di scienze cognitive, dall’altra parte della strada rispetto a “Vassar Street 43”, c’era addirittura il dipartimento dell’intelligenza artificiale, chiamato “Stata Center”, finanziato in parte dal Bill Gates

Ogni giorno avevamo lecture o conferenze di luminari provenienti da tutto il mondo. L’aspetto interessante di quell’esperienza era di avere a portata di mano tutti gli specialisti necessari per il mio progetto, da quelli che elaborano gli algoritmi (bioingegneri) per estrarre informazioni dai segnali sempre più raffinate, a quelli che ne fanno le analisi statistiche, oltre alla possibilità di discutere con neuroscienziati esperti quali fossero gli indicatori più adatti per gli obiettivi della nostra ricerca.

Il professore del MIT Emery Neal Brown, affiliato anche con l’Università di Harvard, sempre in Neurostatistica, e presso il Massachusetts General Hospital, è un guru di statistica applicata al campo dei segnali neurologici di vario genere (non solo di segnali psicofisiologici o di elettroencefalografia, ma anche di segnali estratti dalla risonanza magnetica funzionale o da altre tecniche di neuroimmagine) aveva accettato, tramite la collaborazione del suo assistente Riccardo Barbieri, di ospitare il mio progetto di dottorato.

Riccardo Barbieri è poi diventato professore associato di Bioigegneria al Politecnico di Milano, mentre Emery Neal Brown è stato il pioniere nell’analisi dei dati cerebrali e dello sviluppo delle metodologie di computational neuroscience legate al “Point Process”: nella statistica e nella teoria della probabilità, un “processo puntuale” o un “campo di punti” è una raccolta di elementi matematici, disposti casualmente su uno “spazio matematico sottostante”, come per esempio una linea reale, un piano cartesiano o spazi più astratti. I “processi puntuali” possono essere quindi usati come modelli matematici di fenomeni o oggetti rappresentabili come punti in qualche tipo di spazio. Il point process ha avuto grandi applicazioni del campo della “computational neuroscience”.

Assieme al prof. Riccardo Barbieri, avevamo condotto una ulteriore ricerca per cercare di risolvere il nostro problema: trovare degli stati “universali” di stress e di rilassamento, per utilizzarli come induttori di stati emotivi prototipici: se fossimo riusciti a farne la radiografia, in termini di pattern psicofisiologici, avremmo potuto rapportare eventuali reazioni emotive a questi parametri prototipici, così da riuscire a ricostruire uno spazio matematico all’interno del quale “calibrare” tutte le risposte possibili in termini psicofisiologici. Decidemmo di aumentare i sensori elettroencefalografici: non più uno soltanto, posizionato sulla sommità del capo, ma metterne 4, sulla fronte: due sulla parte destra, e 2 sulla parte sinistra: anche questo fu un ottimo progresso che rivelò dati promettenti.

Lungo la strada ci rendemmo così conto che era anche importante avere una misura di quanto il soggetto potesse eccitarsi sotto stress, ossia trovare un punto minimo e massimo dei suoi stati emozionali, e verificare se dopo una fase di stress, le persone riuscivano a tornare nello stato di relax oppure no.

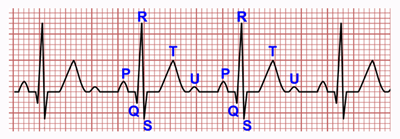

Dopo la nostra seconda sperimentazione, i cui dati sono stati pubblicati nel 2010 (qui lascio un link: https://www.ncbi.nlm.nih.gov/pmc/articles/PMC3059749/ ; per chi volesse guardarsi la pubblicazione online oggi disponibile sul sito del “National Institute of Health (NIH) Americano) scoprimmo che per rilassare i soggetti funzionavano bene i panorami naturali, soprattutto marini e di montagne, e che ci volevano parecchi minuti, perfino un quarto d’ora, affinché una persona raggiungesse il cosiddetto “ritmo basale”, ovvero un “ritmo dei trend neuro e psicofisiologici” di totale riposo da usare come punto di partenza per misurare la reazione emotiva a stimoli successivi. Uno dei dati più interessanti, è la scoperta che i segnali che correlavano in modo significativo con lo scoring di un questionario psicologico (lo “State Trait Anxiety Inventory” o “STAI”, molto riconosciuto a livello internazionale per misurare lo stato psicologico di stress e relax), erano la Skin Conductance (sudorazione della pelle) e la distanza media tra un battito e l’altro del cuore (in gergo tecnico definito come “RR interval”, ovvero la distanza media tra il picco dell’onda “R”, quella più ampia di un tracciato elettrocardiaco classico (come mostrato in figura qui sotto):

Un ulteriore dato interessante che emerse da questi test fu il peso del “vissuto culturale”: a Boston, con gli studenti americani che partecipavano ai nostri test, funzionavano particolarmente bene le spiagge tropicali; ma per delle persone nate su isole immerse nei mari cristallini dei caraibi, le immagini caraibiche avrebbero potuto generare noia. Ciò era successo infatti con uno studente jamaicano che aveva partecipato al nostro esperimento.

Tanto per fare un ulteriore esempio, mi capitò -anche uno studente che non si rilassava quando esposto ai nostri stimoli. Vedevo che i suoi parametri non erano quelli tipici del rilassamento: il battito cardiaco era accelerato, la sudorazione della pelle era elevata, e le onde cerebrali non andavano in ritmo alfa, tipicamente correlate con stati di rilassamento: alla fine del test, gli chiesi se si era sentito rilassato dai nostri stimoli emotigeni: emerse che la foto del mare gli ricordava la sua ragazza che lo stressava per andare in Costa Rica e lui non aveva i soldi per portarcela, ciò era alla base di discussioni e litigi. Per questa ragione, avevamo sempre dovuto coinvolgere grandi numeri di persone e integrare delle scale psicologiche per avere la certezza sul fatto che gli stimoli emotigeni stessero effettivamente inducendo gli stati di stress e relax che noi avevamo ipotizzato, con l’obiettivo di dimostare che lo stato misurato dalla scala psicologica correlava con il correlato biologico misurato dai sensori.

Nel frattempo, ebbi la fortuna di incontrare sempre al MIT un altro personaggio chiave, il professore Tommaso Poggio, che aveva elaborato i primi algoritmi dell’intelligenza artificiale.

Tommaso cercava il modo di far riconoscere gli oggetti a un computer, e usava degli algoritmi chiamati “Support Vector Machines” per permettere ai computer di riconoscere gli oggetti in modo sempre più preciso e corretto

Provammo ad applicare i suoi algoritmi ai dati fisiologici (composti da dati con parametri sulla respirazione, battito cardiaco, sudorazione e segnali elettroencefalografici) che avevamo collezionato in stato sia di stress che di relax, ottenendo un risultato eccezionale: l’algoritmo ci indovinava al 95%! Avevamo così applicato uno dei primi algoritmi di riconoscimento automatico delle emozioni, e per la prima volta sembrava possibile realizzare un sistema in grado di riconoscere in modo automatizzato le reazioni emotive

Il passo successivo fu completare le rilevazioni degli stati di eccitazione e rilassamento con quelli di coinvolgimento emotivo ottimale per ottenere il pattern neuro e psicofisiologico della valenza, ossia la comprensione se lo stato di emozione provato dal soggetto fosse positivo o negativo, dato estratto con particolare successo dai segnali elettroencefalografici presi dalla fronte, sia sul lobo destro che su quello sinistro.

Arrivato a questo punto avevo finalmente in mano i materiali necessari per la mia tesi di dottorato. La mia conclusione fu di rilevare i parametri psicofisiologici degli studenti a distanza integrando dati cardiaci, di sudorazione della pelle ed elettroencefalografici, che potessero “accendere” le luci di un semaforo (inserito nella piattaforma software del docente che gestiva le lezioni a distanza) tramite tre colori con cui rappresentare il livello di coinvolgimento: se le luci fossero state verdi, avrebbe indicato che la classe era attenta; rosso o giallo, invece, stress e distrazione (relax) rispettivamente.

In questo modo il docente poteva avere un feedback dello stato del coinvolgimento degli studenti remoti in tempo reale e intervenire per richiamarli o comunque ridestare il coinvolgimento emotivo ottimale.

La tecnologia era però un po’ invasiva, perché richiedeva di indossare degli anellini sulle dita e dei sensori sul capo, in particolare sulla fronte. Inoltre, la misurazione era legata all’emozione, non all’attenzione degli allievi. Non era cioè possibile sapere se l’emozione provata era legata al contenuto della lezione o a qualche fattore di distrazione esterna alla lezione.

Fu un altro incontro fortuito a sbloccare la situazione. A un congresso che si era tenuto proprio a Boston nel 2006 (il famoso SIGGRAPH – Special Interest Group on Computer Graphics and Interactive Techniques – che fortunatamente quell’anno si tenne proprio a Boston, e io riuscii ad andarci solo perché ero al MIT), incontrai quelli dell’azienda svedese Tobi, specialisti del tracciamento oculare o Eye-Tracking. Per la prima volta in vita mia, vidi un eye-tracker in azione: ne rimasi a dir poco affascinato fin da subito. Il giorno dopo, scoprii che al piano sopra rispetto ai laboratori di Emery Brown e Riccardo Barbieri c’era un professore, di nome Pawan Sinha, che ne aveva uno perché studiava i fondamenti neuroscientifici della visione.

Legando la misurazione dell’emozione al tracciamento oculare di quello che il soggetto stava guardando trovai il modo di capire se lo emozionava, collegando in modo scientifico emozione e attenzione: era l’alba del futuro Neuromarketing! Scoprii anche l’importanza della dilatazione pupillare, un altro parametro psicofisiologico che rileva l’attivazione emozionale del soggetto.

Testammo il protocollo di rilassamento con le spiagge caraibiche con l’eye-tracker e scoprimmo che le pupille si restringevano col rilassamento e si allargavano con lo stress. Questa scoperta ci permetteva di ridurre la strumentazione semplicemente all’eye-tracker, eliminando i sensori e potendo monitorare il soggetto senza toccarlo e senza che lui fosse infastidito dal fatto di essere “monitorato”.

L’aspetto dell’invasività dei sensori è importante, perché il soggetto che sa di avere addosso dei sensori subisce comunque una alterazione emozionale, che andrebbe filtrata. Con l’osservazione invece da remoto delle pupille si apriva una nuova frontiera.

Tieni anche conto che ci sono voluti anni per estrarre dal tracciamento pupillare dati come il battito cardiaco. Nel 2006, comunque, riuscimmo ad agganciare l’emozione con l’attenzione, cogliendo un notevole successo.

Il passo successivo fu un nuovo studio con il professor Pawan Sinha per la ricerca sui pazienti autistici utilizzando la rilevazione delle emozioni tramite il rilevamento oculare e le reazioni psicofisiologiche in simultanea. Nella mia tesi finale di dottorato riuscii così a inserire anche una parte relativa a questa metodologia.

Avevo dubbi se restare o no al MIT, Pawan voleva che restassi, perché potevamo proseguire le ricerche. Decisi comunque di tornare a casa, portandomi in Italia moltissimi dati e sviluppi, sdoganando scientificamente il principio della riconoscibilità degli stati emotivi sulla base dei segnali psicofisiologici rilevati in tempo reale oltre al ruolo dell’eye-tracker, che apriva nuovi mondi.

Una volta rientrato a Milano, mi venne offerta l’opportunità di continuare le mie ricerche presso l’università IULM applicandole a quello che per me era una nuova branca, la comunicazione e il neuromarketing. Tutto però parti dagli studi che avevo fatto al MIT di Boston e al materiale che avevo raccolto.

Una volta rientrato in Italia nel 2007, e avere conseguito il dottorato, ho iniziato un assegno di ricerca nel 2008 presso l’Università IULM di Milano, sempre in collaborazione con il prof. Villamira e con il prof. Luca Pellegrini: iniziammo un nuovo studio, in cui cercare di valutare l’esperienza suscitata da un social network che avevo scoperto in America: Facebook. Con mia grande sorpresa, al rientro dagli USA in Italia, scoprii che l’uso di Facebook era agli albori, ed era usato principalmente da studenti e aveva un grande successo. Ora era arrivato il momento di mettere a frutto tutti gli studi sviluppati fino a quel momento: usare gli stati di stress e relaxation, per valutare l’esperienza emotiva di una esperienza di successo. L’idea era molto semplice. Se Facebook era di così grande successo, grazie al suo rapido diffondersi in quegli anni, doveva essere sicuramente in grado di elicitare una esperienza emotiva di “optimal engagement”. Era quindi una modalità ottimale con cui tentare di “fotografare” la “signature” psicofisiologica dell’ “optimal emotional engagement”, e paragonare tale “pattern” a quello di “relax” e “stress”, testando il processo di “calibrazione” emotiva.

Tale studio rivelò risultati molto positivi: tutti i dati sono stati pubblicati nel 2011, ed è ad oggi uno dei miei articoli scientifici più citati in assoluto (ben più di 250 volte, in 250 pubblicazioni scientifiche diverse): in questo articolo si mostra, con dati statisticamente significativi, come sia possibile misurare l’esperienza di coinvolgimento ottimale tramite diversi parametri psicofisiologici, sincronizzati con i dati eye tracking.

Quando il prof. Villamira andò in pensione, nel 2012 iniziai successivamente a collaborare con il prof. Vincenzo Russo, il quale aveva deciso di fondare un laboratorio, il “Behavior & Brain Lab” per applicare gli studi di neuroscienze e di psicofisiologia presso l’Università IULM di Milano al mondo della comunicazione, un ambito a cui l’università IULM era molto interessata.

Grazie all’appoggio del prof. Vincenzo Russo, portai avanti per altri 4 anni le mie ricerche presso il Behaviour and Brain Lab, nato grazie alla joint venture con un’azienda di Vicenza che offrì la strumentazione. In un secondo momento, si aggregò anche il Politecnico, con i professori Luca Mainardi e Riccardo Barbieri che nel frattempo era rientrato anche lui in Italia dagli USA ed è diventato professore associato presso il Politecnico di Milano. Nelle ricerche successive condotte in Italia, , avevamo studiato i correlati neuro- e psico-fisiologici delle emozioni di base (paura, rabbia, tristezza e gioia), generando una nuova pubblicazione (M. Mauri, F. Onorati, V. Russo, L. Mainardi, R. Barbieri, “Psychophysiological assessement of emotions”, International Journal of Bioelectromagnetism, 2012, Vol. 14, No. 3: 133-140), in cui dimostravamo che usando solo indicatori psicofisiologici legati alla attività cardio-repiratoria era possibile distinguere tra le diverse emozioni considerate.

Nel gruppo dei ricercatori si erano poi inseriti anche Giulia Songa e Andrea Ciceri, che avevano fatto la loro tesi di dottorato presso il laboratorio sul tema del Neuromarketing. Allo IULM portammo avanti la ricerca di base sulla dilatazione pupillare e sui segnali psicofisiologici. A ogni battito cardiaco corrisponde una dilatazione lieve delle pupille. Con uno studio dimostrammo che non solo puoi derivare il battito cardiaco dalla misurazione pupillare, ma anche lo stato emotivo e dire se uno stimolo è più emozionale di un altro. avevamo dimostrato che la dilatazione pupillare non solo rivela gli stati emotivi, ma permette addirittura di derivare il battito cardiaco attraverso le oscillazioni pupillari suscitate dalle contrazioni del cuore ad ogni battito, e riuscimmo a dimostrare inoltre che era possibile sfruttare tale segnale neurofisiologico derivato dai dati eye-tracking per dedurre se la persona provava emozione oppure no dinnanzi a stimoli visivi. Tali dati furono pubblicati nel 2013 (F. Onorati, R. Barbieri, M. Mauri, V. Russo, L. Mainardi, “Characterization of affective states by pupillary dynamics and autonomic correlates”, Frontiers in Neuroengineering ).

Forse non siamo stati i primi al mondo in questa metodologia, ma sicuramente tra i leader. Purtroppo, anche se abbiamo dimostrato che in teoria è possibile dedurre lo stato emozionale solo dagli occhi, farlo in pratica non è facile. Per questi studi abbiamo dovuto oscurare la stanza, misurare la luminosità dello schermo e controllare altri parametri nelle dinamiche della dilatazione pupillare che richiedono notevoli processamenti bioingegneristici dei segnali. I soggetti erano cioè in condizioni super controllate. Siamo comunque assai lontani dal dire cosa stai pensando semplicemente guardandoti con una fotocamera, possiamo dedurre le reazioni emotive.

Nel frattempo, si svilupparono delle tecnologie alternative basate sul rilevamento e l’interpretazione dei movimenti dei muscoli facciali che si integrarono allo sviluppo commerciale del nostro approccio, che resta vivo e valido a livello accademico e a livello di business da parte delle aziende che applicano il neuromarketing.

Infatti, i sistemi basati sull’interpretazione delle espressioni facciali sono meno sensibili, ci vuole un livello elevato di eccitazione emotiva del soggetto per poter avere dei ”riverberi” emotivi sul volto, mentre anche qualora la persone resti sempre con la faccia inespressiva, grazie all’uso di sensori neuro e psicofisiologici si può inferire lo stato emotivo in modo più preciso.

In conclusione, se mi vai a misurare le reazioni dei soggetti a un portale bancario con questi software che misurano solo le espressioni emotive del volto, i risultati che si raccolgono potrebbero essere scarsi. Per avere misurazioni di maggiore rilievo bisogna invece utilizzare i parametri psicofisiologici, molto più sensibili e precisi.

Comunque, allo IULM scoprimmo che i veri risultati saltano fuori combinando in modo opportuno tutte queste tecnologie, ad esempio eye-tracker, misure biologiche e software facciali. In questo modo riuscimmo a costruire una metodologia alternativa alla fMRI (risonanza magnetica funzionale) utilizzata fino ad allora nelle ricerche di neuromarketing come principale tecnica neuroscientifica.

Per capire l’importanza dei nostri risultati, considera che il problema della fMRI non è solo di essere molto invasiva (in quanto obblighi i partecipanti a sdraiarsi all’interno del tubo), ma anche estremamente costosa. Le ricerche con la risonanza magnetica funzionale costano qualcosa come 500 euro al minuto!

La forza del nostro approccio era invece di abbattere notevolmente sia i costi che l’invasività rendendo questi studi alla portata delle aziende e delle applicazioni pratiche sia nel neuromarketing che nel design.

Nasceva così la grande avventura del neuromarketing italiano, che sotto il profilo della metodologia della combinazione del tracciamento oculare con il rilevamento dei dati psicofisiologici si può considerare veramente pionieristico. Il nostro approccio si è poi diffuso in tutto il mondo ed è quello comunemente adottato in Europa e in America.

E la mia tesi di dottorato? Alla fine, ha avuto anch’essa un risvolto pratico. Dopo qualche anno, è finita in un grosso progetto di una banca nazionale che voleva studiare il livello di coinvolgimento a distanza dei suoi manager e testare i vari pacchetti formativi elaborati per loro”.

Ringraziamo il professor Maurizio Mauri per aver condiviso con noi la sua esperienza, oltre a un pezzo della storia della misurazione delle emozioni con le neuroscienze.

Ti è piaciuto questo articolo? Iscriviti alla newsletter per ricevere contenuti simili. Oppure, leggi il mio ultimo libro, Neuroscienze della narrazione.